O tym, że NVIDIA dominuje na rynku kart graficznych raczej nie trzeba nikogo przekonywać. O tym, że gracze chętniej wybierają grafiki od „zielonych” już od wielu lat też powszechnie wiadomo. Tak samo jak o tym, że NVIDIA, póki co, przedstawia się jako większy innowator od konkurencji w postaci AMD. Kto pierwszy wprowadził śledzenie promieni w czasie rzeczywistym do konsumenckich kart graficznych? Kto wprowadził metodę wygładzania obrazu opartą o sztuczną inteligencję? Ano NVIDIA!

Wprowadzenie ray tracingu (RT), czyli rzeczonego śledzenia promieni, miało stać się istną rewolucją w grach. W wyobraźni graczy po premierze GeForce’ów RTX 2000 każdy tytuł miał zyskać praktycznie fotorealistyczną pod kątem oświetlenia grafikę i wprowadzać pecetowych graczy do kolejnej epoki w historii gamingu. Dziś oczywiście wiemy, że tak się nie stało. Przynajmniej na razie producenci nie spieszą się z wydawaniem gier z RT oraz DLSS, chociaż w ostatnim czasie zaczęło ich przybywać. Dotyczy to głównie największych studiów deweloperskich.

Nie można zaprzeczyć jednak, że premiera pierwszych RTX-ów była niewątpliwym sukcesem firmy zarządzanej przez Jen-Hsuna Huanga, nazywanego też Jensenem Huangiem. Tylko że sam ray tracing nie zrobił jakiegoś wielkiego wrażenia. Owszem, pojawiły się gry będące praktycznie benchmarkiem dla tej technologii – Metro Exodus wyglądało wspaniale, a Battlefield V, chociaż grą samą w sobie był… no wiecie, że nie najlepszą, to jednak dzięki RT pod kątem grafiki wyglądał świetnie.

Bardzo dobrze wypadła także najnowsza gra studia Remedy – Control. Tam różnica wizualna pomiędzy włączonym a wyłączonym RT była ogromna. Mniej spektakularnie zaprezentował się Shadow of the Tomb Raider oraz Call of Duty: Modern Warfare, ale RT swoją rolę spełniał.

Bez wątpienia – premiera RTX-ów była gorąca i obietnice w postaci renderów pokazowych odpowiednio rozgrzały głowy i fantazje zdecydowanej większości graczy. Ale użytkownicy potrafiący spojrzeć z nieco szerszej perspektywy na rozwój gier i grafiki, zachowywali więcej powściągliwości spodziewając się, że pierwsza generacja z pewnością nie będzie tą, która pokaże prawdziwe oblicze kart graficznych obsługujących ray tracing i DLSS. Tym bardziej, że AMD od dłuższego czasu odgrażało się, że pracuje nad kartami graficznymi obsługującymi śledzenie i symulowanie promieni w czasie rzeczywistym i wcale nie będą do tego potrzebne osobne rdzenie (rdzenie RT, jak je nazwała NVIDIA, w które wyposażone są karty graficzne z rodziny GeForce RTX oraz Quadro RTX).

Dlatego gracze z niecierpliwością wyglądali premiery nowych kart graficznych od NVIDII – Ampere. Poprzednia generacja, oparta na architekturze Turing, dopiero zapoczątkowała to, co rozwinąć miały właśnie karty z rodziny RTX 3000. I ewentualne konkurencyjne GPU od AMD. Bo chcąc nie chcąc – to właśnie na rdzeniach graficznych od AMD opierają się chipy graficzne w najnowszych konsolach Xbox oraz PlayStation 5. Czy się to fanom NVIDII podoba, czy nie – będą one umożliwiać obsługę śledzenia promieni w czasie rzeczywistym, więc „zieloni” przestali być pod tym względem wyjątkowi. A poza tym, dopiero w październiku dowiemy się, co „czerwoni” mają w tym temacie do zaoferowania PC Master Race.

Wracając do samej NVIDII – już od paru lat każda kolejna generacja GPU przynosi ze sobą potężny skok wydajności w stosunku do poprzedniej. Tak było z przejściem z Maxwella na Pascala, a także z Pascala na Turinga. Teraz zaś, po morzu przelanych plotek, przecieków i mniej lub bardziej wiarygodnych zapowiedzi, w dniu premiery okazało się, że Turing także powinien spakować swoje manatki, podziękować za współpracę, przytulić graczy i grzecznie odejść do krainy, gdzie liczba wyświetlanych klatek na sekundę nie ma znaczenia. Tak, architektura Ampere bezpardonowo potraktowała swojego poprzednika. Na co więc można liczyć na chwilę obecną?

Generacja RTX 3000 w skrócie

Nowe GeForce’y RTX rozwijają właściwie wszystkie elementy, które posiadacze kart graficznych poprzednich generacji już zdążyli dobrze poznać. Nie zabrakło oczywiście także nowości.

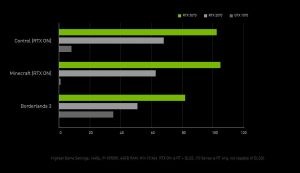

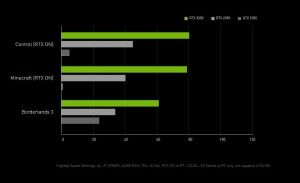

Najwięcej uwagi poświęcono ponownie, a jakże, ray tracingowi, od którego przecież nowe karty NVIDII wzięły swoją nazwę. To dlatego wszystkie karty graficzne posiadające w swoim układzie rdzenie RT, bezpośrednio odpowiedzialne za wydajność śledzenia promieni w grach, stały się RTX-ami, a grafiki pozbawione tego elementu pozostały GTX-ami. Grafiki oparte na 8-nanometrowej architekturze Ampere otrzymały nie tylko więcej jednostek RT (drugiej generacji) niż ich bezpośredni poprzednicy, co przekłada się na wyższą wydajność w grach z włączonym ray tracingiem, ale też podniesiono ich wydajność. Przykład Dooma Eternal pokazuje, że końcowy rezultat wypada mocno na korzyść nowych kart, a różnice potrafią być naprawdę znaczące. GeForce RTX 3080 posiadający 68 rdzeni RT okazał się wydajniejszy od RTX-a 2080 Ti o ok. 50%. Co ciekawe, 2080 Ti posiadał taką samą liczbę rdzeni RT, ale była to ich pierwsza generacja. A poza tym, jego bezpośrednim następcą jest RTX 3090. Niemal identyczny wzrost wydajności uzyskano w Control oraz Minecraft z włączonym ray tracingiem.

Druga odsłona RTX-ów wyposażona została także w obsługę PCI Express 4.0. Nowa generacja standardu PCIe coraz śmielej zaznacza swoją obecność na rynku. Już w ubiegłym roku w sklepach pojawiły się płyty główne z szyną PCIe 4.0 dla procesorów AMD Ryzen 3000, a później do sprzedaży trafiły dyski z nowym, wydajniejszym interfejsem. Z nową wersją złącza współpracują także karty graficzne od „czerwonych” z rodziny Radeon RX 5600 oraz 5700, w tym także profesjonalne Radeony Pro. Co ma nam dać zaktualizowany standard PCI Express w kartach graficznych? Przede wszystkim większą przepustowość, co ma przełożyć się na osiągi. Jednak póki co różnice pomiędzy kartą umieszczoną w szynie PCIe 3.0 a nowszym wariantem są niewielkie (najbardziej widoczne w rozdzielczości Full HD. Im rozdzielczość wyższa, tym różnice są mniej widoczne) lub… żadne. Bardziej zainteresowanych tematem odsyłam do świetnej publikacji dotyczącej różnic pomiędzy dwoma ostatnimi generacjami standardu PCIe w kontekście kart graficznych przygotowanej przez serwis Techspot.

W RTX-ach serii 3000 pojawi się także zaktualizowane do wersji 2.1 złącze HDMI. Co to oznacza? Że posiadacze ekranów o rozdzielczości 4K będą w stanie wyświetlać do 120 klatek na sekundę, a nabywcy telewizorów 8K – 60 klatek na sekundę.

DLSS 2.0

Pierwsza odsłona DLSS (Deep Learning Super Sampling), czyli innowacyjnej technologii mającej na celu wygładzić i wyostrzyć obraz za pomocą upscalingu (przekonwertowaniem do wyższej rozdzielczości) oraz uczenia maszynowego, a jednocześnie zwiększyć liczbę wyświetlanych klatek na sekundę, zaprezentowała się dwa lata temu. Brzmi jak spełnienie marzeń każdego gracza – obraz nie dość, że miał wyglądać lepiej pod kątem ostrości i wyeksponowanych detali, to jeszcze miał być płynniejszy niż bez włączonego DLSS. Narzędzie to wykorzystuje w tym celu rdzenie Tensor zaimplementowane w chip graficzny i są one niezbędne do działania tej technologii. Jednak pierwsza odsłona DLSS nie okazała się jakimś spektakularnym sukcesem, o czym świadczy liczba gier wyposażonych w odpowiednia ustawienia. Mówiąc skrótowo – było ich po prostu mało. Powód? Sztuczna inteligencja musiała „uczyć się” każdej gry osobno, co było dość czasochłonne i mało wygodne. Obecnie szkolenie SI przebiega dużo sprawniej dzięki wykorzystaniu różnego materiału źródłowego i usprawnieniu algorytmów. W ten sposób po dwóch latach od premiery technologia ta dotarła do wersji 2.0

W nowym wariancie DLSS zaprezentował zupełnie nowy poziom, zarówno pod kątem skalowania, wygładzania i szczegółowości obrazu, jak i pod kątem wydajności. DLSS 2.0 korzysta z nowych algorytmów uczenia maszynowego, a sama technologia potrafi teraz jeszcze efektywniej korzystać z rdzeni Tensor, co wpływa oczywiście bezpośrednio na liczbę wyświetlanych klatek animacji na sekundę. NVIDIA osiągnęła z wersją 2.0 rezultaty wręcz niebywałe i słowo to w żaden sposób nie oznacza przesady. Doszło do tego, że w Death Stranding natywny obraz w rozdzielczości 4K wyglądał gorzej niż przeskalowany przez SI do 4K z Full HD.

DLSS w nowej wersji posiada kilka trybów działania: od „Quality”, gdzie na pierwszym miejscu jest jakość obrazu, do „Ultra Performance” nastawionym na wyświetlanie możliwie największej liczby klatek na sekundę kosztem jakości obrazu. Na powyższym przykładzie zastosowano ustawienia „Quality”, a liczba klatek animacji i tak wzrosła ponad dwukrotnie.

Spostrzegawczy czytelnicy zauważyli z pewnością, że materiał przygotowany przez NVIDIĘ wykorzystywał RTX-a 2060, co oznacza, że DLSS 2.0 dostępny jest także dla posiadaczy „starych” RTX-ów.

NVIDIA Broadcast

Wraz z premierą nowych grafik, NVIDIA wprowadziła nowe narzędzie dla osób streamujących swoją rozgrywkę. Wcześniej było to możliwe za pomocą jednej z funkcji GeForce Experience. Teraz jednak „zieloni” sięgnęli po zupełnie nowe narzędzie – NVIDIA Broadcast, które według obietnic ma zamienić nasz pokój w studio nagraniowe.

NVIDIA już od dobrych kilku lat intensywnie para się badaniami i rozwijaniem sztucznej inteligencji i uczenia maszynowego, więc i tutaj tych dwóch elementów nie zabrakło. SI wykorzystywane jest w celu poprawy jakości dźwięku, np. usuwając wszelkie odgłosy tła, mogące zakłócać przejrzystość transmisji. Sztuczna inteligencja potrzebna jest także do stworzenia wirtualnego „green-screenu” umożliwiającego szybką zmianę tła, na którym się znajdujemy lub jego rozmazanie. Jak twierdzi NVIDIA – tylko nasza wyobraźnia będzie w stanie ograniczyć nas w tym, co będzie znajdowało się na naszymi plecami w czasie nadawania streamu.

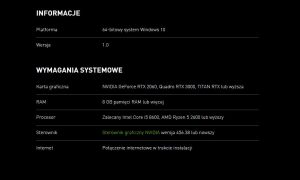

Co mnie najbardziej zaskoczyło, to wymagania sprzętowe aplikacji. Do działania potrzebuje ona karty graficznej z rodziny GeForce RTX (od 2060 w górę), Quadro RTX (od 3000 w górę) lub Titan RTX, czyli najpewniej chodzi o obecność rdzeni Tensor. Do tego przyda się w miarę nowy i mocny procesor (zalecany min. Intel Core i5 8600 lub AMD Ryzen 5 2600) oraz przynajmniej 8 GB pamięci operacyjnej.

NVIDIA Broadcast jest kompatybilna z takimi aplikacjami jak Discord, Twitch, TeamSpeak, Skype, Zoom, Xsplit, Slack, Microsoft Teams oraz wieloma innymi.

NVIDIA Reflex

Wraz z pojawieniem się architektury Ampere, NVIDIA wprowadziła technologię nazwaną Reflex. Pozwala ona na możliwie maksymalne zredukowanie opóźnienia wejścia, czyli tzw. input lagu. W skrócie, to czas potrzebny dla całego systemu na przetworzenie danych od kliknięcia myszą do zobaczenie jego efektu na ekranie – najczęściej jest to wystrzał, jeżeli bierzemy pod uwagę gry FPS.

Jak można się domyślać – im input lag niższy, tym lepiej. Funkcja pozwalająca na obniżenie czasu potrzebnego na przebycie sygnału wychodzącego z myszy i mającego swój finał na ekranie monitora została stworzona głównie z myślą o grach turniejowych, gdzie każda milisekundach ma znaczenie i w skrajnych przypadkach może decydować o zwycięstwie lub porażce.

NVIDIA Reflex nie będzie wymagała do działania grafiki opartej na architekturze Ampere. Korzystać z niej będą mogli także gracze posiadający Maxwelle, czyli karty z rodziny GTX 900. Jednak to najnowsza generacja ma zapewniać najlepsze rezultaty. Do działania NVIDIA Reflex gracze będą potrzebować monitora obsługującego G-Sync. Poniżej przykład działania technologii NVIDIA Reflex. Liczby mają pełne prawo się podobać, nawet jeżeli ktoś nie dysponuje monitorem 360-herzowym ani RTX-em 3080.

RTX-y trzy, każdy jeden mocniejszy

NVIDIA zwykła najpierw przedstawiać swoje najmocniejsze dzieci. I tak w tym roku padło na GeForce’a RTX 3070, RTX 3080 oraz RTX 3090. Nie „3080 Ti”, jak można się było spodziewać. Swoją drogą, premiera też była dość ciekawa – jako, że świat wciąż jest pogrążony w pocovidowym cieniu, CEO i współzałożyciel NVIDII prezentował nowe karty graficzne podczas streamu ze swojej kuchni, przy czym RTX-a 3090 wyciągnął z… piekarnika, przed którym stał.

Przedpremierowe domysły nie były specjalnie oryginalne ani wyszukane – cały czas trąbiono o tym, że druga generacja kart spod znaku RTX będzie wydajniejsza w każdy możliwy sposób: pod kątem wydajności ogólnej, ray tracingu, DLSS i chłodzenia. Generalnie wszystko ma być „bardziej” w stosunku do pierwszej odsłony grafik wyposażonych w rdzenie RT oraz Tensor. Żadne w tym zaskoczenie. Im bliżej premiery kart, tym więcej pojawiało się „przecieków” i innego typu mniej lub bardziej oficjalnych newsów, ale z racji tego, że jest już po premierze, skupmy się na tym, co NVIDIA zaoferowała na dziś dzień. Niech przemówią liczby i realne wskaźniki, bo mówić jest o czym.

GeForce RTX 3070

Zacznijmy od karty graficznej, chyba najbardziej psującej humor graczom, którzy nie tak dawno wyposażyli swoje high-endowe konfiguracje w GeForce’a RTX 2080 Ti wartego na chwilę obecną, w zależności od wersji i producenta, między 5300 a nawet grubo ponad 6000 zł. Otóż okazało się, że RTX 3070 oparty na rdzeniu GA104 jest mniej więcej tak samo wydajny jak RTX 2080 Ti, przy czym wersja Founders Edition została wyceniona na… 2359 zł. Kosztuje zatem ponad dwukrotnie mniej. To właśnie jeden z powodów, dla którego niektórzy gracze są dość mocno wkurzeni na drugą generację RTX-ów.

Specyfikacja karty prezentuje się następująco.

| RTX 3070 | RTX 2070 | |

|---|---|---|

| GPU: | GA104 | TU106 |

| architektura: | Ampere, 8nm | Turing, 12 nm |

| rdzenie CUDA: | 5888 | 2304 |

| jednostki teksturujące: | 184 | 144 |

| rdzenie RT: | 46 | 36 |

| rdzenie Tensor: | 184 | 288 |

| taktowanie zegara: | bazowe: 1500 MHz Boost: 1725 MHz | bazowe: 1410 MHz Boost: 1620 MHz |

| pamięć: | 8 GB GDDR6, 256 bit przepustowość: 448 GB/s | 8 GB GDDR6, 256 bit przepustowość: 448 GB/s |

| wydajność teoretyczna (FP32): | 20,3 TFLOP | 7,5 TFLOP |

| interfejs: | PCIe 4.0 x16 | PCIe 3.0 x16 |

| TDP: | 220 W | 175 W |

| zalecany zasilacz: | 550 W | 450 W |

Jak widać, następca RTX-a 2070 otrzymał sporego kopa pod praktycznie każdym względem. Ponad dwukrotnie więcej rdzeni CUDA, więcej jednostek teksturujących, rasteryzujących oraz rdzeni RT. Do tego dochodzi wyższe taktowanie. Bez zmian pozostała specyfikacja pamięci, a wprawne oko zwróci uwagę na mniejszą liczbę rdzeni Tensor. Jest to jednak ich trzecia odsłona, rzutująca dość mocno na wydajność uczenia maszynowego, w związku z czym NVIDIA postawiła tu po prostu na ich efektywność, a nie liczbę. Podobną sytuację można zaobserwować przy porównaniu RTX-a 3080 do RTX-a 3090. Ogólna wydajność teoretyczna GeForce’a RTX 3070 wynosi 20,3 TFLOP-ów podczas gdy poprzednik mógł pochwalić się wydajnością dla obliczeń FP32 na poziomie 7,3 TFLOP-ów.

GeForce RTX 3080

Na chwilę obecną ciężko mi jednoznacznie stwierdzić, czy to RTX 3070, czy jednak RTX 3080 zostanie nowym królem kart graficznych pod kątem sprzedaży. Za tym pierwszym bezsprzecznie przemawia stosunek ceny do osiągów, ale w drugim przypadku mówimy o… właściwie o tym samym, tylko bardziej. Wariant Founders Edition został wyceniony na 3279 zł, a wydajnością pozostawia najbardziej pokrzywdzonego generacją Ampere RTX-a 2080 Ti daleko w tyle, a od RTX-a 2080 potrafi być wydajniejszy w grach nawet dwukrotnie.

Trudno się dziwić – już sucha specyfikacja GeForce’a RTX 3080 daje dużo do myślenia i pobudza wyobraźnię. Na jej tle ta z bezpośredniego poprzednika generacji Turing wypada może nie blado, ale na pewno nie robi już takiego wrażenia jak dwa lata temu.

| RTX 3080 | RTX 2080 | |

|---|---|---|

| GPU: | GA102 | TU104 |

| architektura: | Ampere, 8nm | Turing, 12 nm |

| rdzenie CUDA: | 8704 | 2944 |

| jednostki teksturujące: | 272 | 184 |

| rdzenie RT: | 68 | 46 |

| rdzenie Tensor: | 272 | 368 |

| taktowanie zegara: | bazowe: 1440 MHz Boost: 1710 MHz | bazowe: 1515 MHz Boost: 1710 MHz |

| pamięć: | 10 GB GDDR6X, 320 bit przepustowość: 760,3 GB/s | 8 GB GDDR6, 256 bit przepustowość: 448 GB/s |

| wydajność teoretyczna (FP32): | 29,8 TFLOP | 10,1 TFLOP |

| interfejs: | PCIe 4.0 x16 | PCIe 3.0 x16 |

| TDP: | 320 W | 215 W |

| zalecany zasilacz: | 700 W | 550 W |

Pierwsze, co rzuca się w oczy, to większa pojemność pamięci operacyjnej. Grafika dysponuje 10 GB pamięci GDDR6X na szynie 320 bitowej zamiast 256-bitowej. W efekcie przepustowość zwiększyła się z 448 GB/s do 760,3 GB/s, co jest nie bez znaczenia dla wydajności całego układu. Warto też na chwilę zatrzymać się przy zasilaniu karty. Jej TDP wzrosło z 215 W do 320 W, co oznacza, że szczęśliwi nabywcy RTX-a 3080 będą musieli przyjrzeć się swojemu zasilaczowi, czy aby jego moc jest wystarczająca do zasilenia nowego GPU. Zalecana moc wzrosła z 550 W do 700 W.

GeForce RTX 3090

Drugi powód wkurzenia graczy. Bo niewątpliwie pierwsze testy jasno wskazują do kogo należy tytuł najwydajniejszej karty graficznej na rynku, ale z drugiej strony okazało się, że układ niemal dwukrotnie droższy od RTX-a 3080 jest tylko o ok. 10-15% od niego wydajniejszy. Gracze liczyli chyba na więcej, szczególnie za kwotę 7029 zł za wariant Founders Edition.

RTX 3090 jest też kolosalnie dużą kartą (a może „cegłą”?) graficzną, więc niewykluczone, że osoby, które już wydadzą na nią pieniądze, będą musiały wziąć pod uwagę, że mogą jej nie zmieścić w nieco mniejszych obudowach, a i o mocniejszym zasilaczu być może trzeba będzie pomyśleć. Chociaż z drugiej strony, jest to układ dla fanatyków segmentu HEDT (High-End Desktops), a oni raczej nie powinni cierpieć z powodu małej obudowy czy zbyt słabego PSU.

NVIDIA chwali się, że GeForce RTX 3090 jest pierwszą kartą graficzną na rynku zdolną obsłużyć obraz 8K w 60 klatkach animacji na sekundę. Brzmi to jak czcza obietnica wyjęta żywcem z filmu pokazującego nieodległą przyszłość, ale fakty są takie, że grafika naprawdę jest w stanie tego dokonać… tylko, że nie w każdych warunkach i nie w każdej grze. Pierwsze testy pokazują, że rozdzielczość 8K, ustawienia Ultra oraz włączony ray tracing w grach go obsługujących to, w zależności od tytułu, od 15 do 40 FPS-ów – przynajmniej wg testów portalu Techradar. Tak więc, aby cieszyć się 60 klatkami na sekundę na ekranie 8K, trzeba będzie znacząco obniżać ustawienia graficzne. Ale może tę kwestię także rozwiąże DLSS.

No dobrze, czas sprawdzić, co sprawia, że RTX 3090 może pochwalić się tak ogromną wydajnością i jak na tym tle prezentuje się do niedawna najmocniejsza grafika dla graczy, czyli RTX 2080 Ti.

| RTX 3090 | RTX 2080 Ti | |

|---|---|---|

| GPU: | GA102 | TU102 |

| architektura: | Ampere, 8nm | Turing, 12 nm |

| rdzenie CUDA: | 10496 | 4352 |

| jednostki teksturujące: | 328 | 272 |

| rdzenie RT: | 82 | 68 |

| rdzenie Tensor: | 328 | 544 |

| taktowanie zegara: | bazowe: 1395 MHz Boost: 1695 MHz | bazowe: 1350 MHz Boost: 1545 MHz |

| pamięć: | 24 GB GDDR6X, 384 bit przepustowość: 936,2 GB/s | 11 GB GDDR6, 352 bit przepustowość: 616 GB/s |

| wydajność teoretyczna (FP32): | 35,6 TFLOP | 13,5 TFLOP |

| interfejs: | PCIe 4.0 x16 | PCIe 3.0 x16 |

| TDP: | 350 W | 250 W |

| zalecany zasilacz: | 750 W | 600 W |

Chwila moment – ponad 10 000 rdzeni CUDA? Ponad dwukrotnie więcej niż w 2080 Ti? Brzmi jak szaleństwo! Do tego dochodzi 24(!) GB pamięci GDDR6X na szynie 384 bitowej pozwalającej na przepustowość 936,2 GB/s. Cała specyfikacja najmocniejszego RTX-a pozwala na uzyskanie 35,6 TFLOP-ów wydajności teoretycznej (FP32), podczas gdy poprzednik mógł pochwalić się wydajnością 13,5 TFLOP-ów. Przypomnę tylko, że RTX 3070 posiada… 20,3 TFLOP-ów.

Pytanie tylko, czy NVIDII uda się w jakiś sposób poprawić wydajność grafiki? Co, zdaję sobie sprawę, w tym kontekście jest pytaniem absurdalnym i zakrawa o miano „problemów pierwszego świata”, ale biorąc pod uwagę różnicę w faktycznej wydajności w grach między nią a RTX-em 3080 wydaje się w pełni zasadnym. Mimo że RTX-owi 3090 nie można odmówić potężnej mocy obliczeniowej, to pod kątem stosunku cena/możliwości na tle grafiki umiejscowionej stopień niżej wypada… tak sobie. I to może skutecznie podciąć sprzedaż RTX-a 3090.

Mamo, nie musisz sprzątać, NVIDIA pozamiatała!

Przeskok wydajnościowy pomiędzy generacją Turing a Ampere jest ogromny. Do tego stopnia, że najmocniejszy układ poprzedniej generacji dla tej jest po prostu przeciętniakiem – oczywiście mówimy cały czas o najwyższej serii kart graficznych NVIDII.

Chociaż wszystkie oczy graczy (nie tylko zresztą, bo profesjonalistów także – nowe sterowniki Studio oraz nadchodzące Quadro RTX i w tym segmencie mogą naprawdę sporo namieszać) są obecnie skierowane na NVIDIĘ, to nie można zapomnieć, że październik przyniesie nam odpowiedź na to, czego można spodziewać się po AMD. Oficjalna prezentacja nowych Radeonów opartych o architekturę RDNA2 szykowana jest na 28 października, a pierwsze przecieki na temat wydajności nowej architektury pokazywały, że jeden z nowych układów od AMD (nie wiadomo dokładnie jaki) osiągał wydajność porównywalną z RTX-em 2080 Ti. I wszystko byłoby w porządku, tylko że wydajność wspomnianego RTX-a 2080 Ti nie robi już na nikim większego wrażenia, a zbliżony potencjał można uzyskać za mniej niż połowę jego ceny decydując się na zakup RTX-a 3070. AMD będzie musiało również wziąć pod uwagę, że to nie jest przecież ostatnie słowo NVIDII. „Zieloni” szykują już RTX-a 3060 oraz 3070 Ti i wiele wskazuje na to, że jeszcze tej jesieni poznanym nowych przedstawicieli architektury Ampere. Miłośnicy laptopów czekają zaś za informacjami o Ampere w wersji mobilnej.

Zatem czekamy!

P.S.: Po premierze NVIDIA wkurzyła graczy raz jeszcze. Tym razem ofiarami stali się jednak nabywcy RTX-a 3080 oraz RTX-3090, a wiąże się to z „crashowaniem” gier podczas rozgrywki. Na ten temat więcej pisał Szymon, więc odsyłam do jego newsa na ten temat. Pozostaje pytanie, w jaki sposób NVIDIA i producenci kart niereferencyjnych poradzą sobie z tym problemem.